(article rédigé par nos stagiaires en formation du parcours expert·e en stratégies webmarketing)

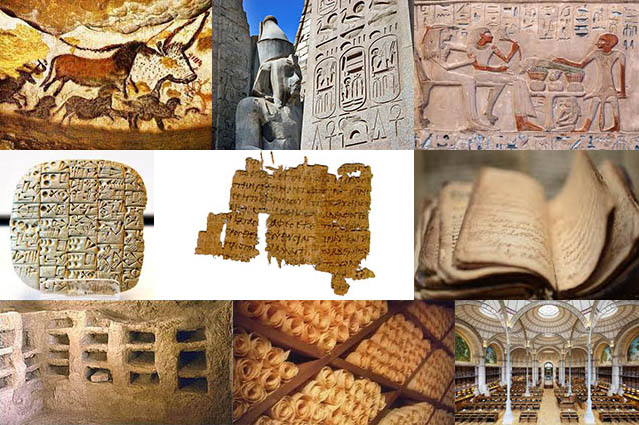

Depuis toujours, l’humanité a créé des centres de données. Avec la naissance des données mobiles, il a consacré des lieux pour les classer, les consulter et les archiver. Jusqu’à la fin du XXème siècle il a conservé ces données sous forme de bibliothèque.

A l’arrivée de l’informatique, la donnée s’est dématérialisée, mais son stockage est resté physique. C’est avec la naissance des réseaux qu’elle a pu être diffusée de façon décentralisée par des disques partagés.

Simple disque dur rajouté au Pc, puis armoire supplémentaire dans un couloir, et ensuite pièce dédiée, les serveurs n’ont cessés de grandir.

Avec l’augmentation de la vitesse des réseaux et face aux problèmes de bruit, de réfrigération, de sécurité et de coût de maintenance, certaines structures ont créé des lieux spécifiques pour héberger leurs serveurs et devenir des centres de données.

Composantes

- Les serveurs, qui hébergent les bases de données, les applications et les sites internet

- Les baies de stockage

- Une architecture réseau

- Une unité de distribution d’énergie

- Un système de climatisation

- Un système de récupération d’énergie

- Un système de protection informatique

- Un système de protection incendie

- Un système de protection contre les intrusions

Classification

En fonction de leur niveau de fiabilité il existe une classification (Uptime institute), les Tiers :

- Niveaux I : basic

- Niveaux II : redondance, tout est doublé, un arrêt par ans pour maintenance

- Niveaux III : maintenabilité sans arrêt informatique

- Niveaux IV : maintenabilité sans impact informatique, résolution de pannes et incidents graves sans interruption du service.

Types

Hyperscale datacenter

Traitement, capacité de calcul et stockage de très grande capacité, plusieurs dizaines de milliers de machines, superficie de plusieurs milliers de mètres carrés, ils sont généralement implantés dans des lieux à faible coût énergétique et, ou, dans les pays froids pour une climatisation plus économique.

Edge datacenter

Proche des grandes agglomérations, il réduit la distance avec l’utilisateur, il diminue la charge sur le réseau et le temps de latence, permettant un service plus sûr et plus rapide.

Core datacenter

Situé aux emplacements d’arrivée des fibres et terminaisons des câbles marins il est le hub de l’interconnexion direct et permet de transporter les données de ses clients sans passer par internet.

Modularité

Un centre de données modulaire est un centre dont la capacité peut être ajustée par ajout ou retrait de module de serveur autonomes qui peuvent avoir l’aspect de conteneurs. Il a été imaginé pour pallier aux problèmes de taille critique auxquels les centres de données peuvent être confrontés et permet d’ajuster, à la hausse ou à la baisse et à faible coût les capacités des centres en fonction des besoins.

Propriétaire ou colocation

Les centres de données peuvent être privés comme par exemple ceux des géants du web, des télécommunications, par choix stratégique.

Mais ils peuvent être aussi en colocation pour mutualiser les coût énergétiques, la sécurité et l’entretient. Les entreprises peuvent louer un espace physique mais aussi du stockage, du traitement et tous les services proposés par le prestataire.

Problèmes écologiques et économiques

La quantité croissante de centre de données pose de sérieux problèmes de consommation d’énergie, d’utilisation de métaux et minéraux rares, de pollution, avec peu de création d’emplois.

“Faut-il limiter le nombre des data centers ?” – Vox Pop – ARTE :

https://www.youtube.com/watch?v=y923bPwAot0

Conclusion :

Ainsi avec les data centers notre mémoire est condamné à être dupliquée sans cesse pour demeurer pérenne !

“C’est comment un data center”, extrait.

Quelques infos en 2020

Interxion construit le plus gros datacenter de France, près de Paris juin 2020 :

Sur un ancien site industriel d’Airbus Helicopters près de Paris, l’hébergeur informatique Interxion lance la construction d’un méga datacenter de 40 000 m2, présenté comme le plus gros en France. Cet investissement d’environ 1 milliard d’euros s’inscrit dans une nouvelle vague d’expansion des géants du cloud et de l’internet faisant de Paris le troisième site d’implantation en Europe derrière Londres et Francfort.

Dell et Microsoft dominent le marché des Data Centers juin 2020 :

Les principaux segments hardware des serveurs, du stockage et du networking représentent 73% des 35,8 milliards de dollars du marché des infrastructures de Data Center. Le reste est représenté par les OS, les logiciels de virtualisation, la sécurité des réseaux et la gestion Cloud. Inspur est le vendeur qui a rencontré la plus forte croissance dans ce domaine au premier trimestre.

L’expérience de data center sous-marin de Microsoft est un succès ! septembre 2020 :

Il y a deux ans, Microsoft avait lancé les tests de son projet de data center sous-marin au large de l’Écosse. Il y a peu, l’édifice a été remonté et les premiers constats ont été rendus publics. Selon la firme, non seulement ce procédé est plus écologique, mais celui-ci est également gage d’une plus grande fiabilité.

La suite : https://sciencepost.fr/lexperience-de-data-center-sous-marin-de-microsoft-est-un-succes/

Le big bang du big data juillet 2020 :

Selon les estimations publiées dans le Digital Economy Compass 2019 de Statista, le volume annuel de données numériques créées à l’échelle mondiale a été multiplié par plus de vingt au cours de la dernière décennie et devrait s’approcher de 50 zettaoctets cette année. Comme le montre notre infographie, cette quantité de données apparaît finalement dérisoire en comparaison avec ce qui est attendu pour les quinze prochaines années.

Article rédigé par Pascal Despin

Publié le 22 mars 2021